M3, un sistema para saber de qué hablan los medios de comunicación

Por Marytere Narváez

Mérida, Yucatán. 1 de octubre de 2018 (Agencia Informativa Conacyt).- ¿Sabes cuántas veces se ha publicado en los principales medios electrónicos mexicanos la palabra “ciencia”? Al menos 399 veces de enero de 2016 a agosto de 2018, de acuerdo con la plataforma http://m3.geoint.mx/ del Centro de Investigación en Ciencias de Información Geoespacial (Centrogeo), unidad Yucatán.

El grupo de investigación de Geointeligencia computacional de Centrogeo, unidad Yucatán, desarrolla el proyecto Monitoreo de Múltiples Medios (conocido también como M3), un sistema de obtención, análisis y visualización de información publicada en medios masivos de comunicación en su versión electrónica.

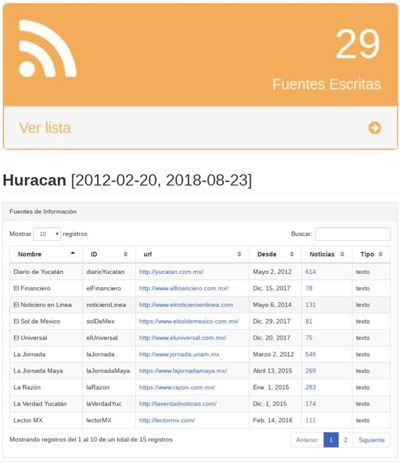

En entrevista para la Agencia Informativa Conacyt, el ingeniero Mario Chirinos Colunga, investigador del Centrogeo encargado del proyecto, describió que la base de datos consta hasta el momento de 45 fuentes de información en texto y nueve fuentes de audio, con un total dos millones 285 mil 926 documentos de texto y 29 mil 981.35 horas de audio.

“No todos los diarios tienen una hemeroteca, y de los que la tienen no en todos los casos se puede realizar una búsqueda adecuada y en otros casos las noticias solo están disponibles por un periodo de tiempo. Solo unos pocos diarios, como La Jornada, tienen bien organizada su información. Por lo que nuestro sistema M³ nos permite tener una base de datos única para hacer búsquedas y realizar diversas investigaciones”.

Además de las fuentes de texto, se monitorea y almacena el audio de 10 estaciones de radio durante la transmisión que realizan de 6:00 a 24:00 horas, misma que se transcribe automáticamente utilizando un transcriptor llamado CMU Sphinx.

Además de las fuentes de texto, se monitorea y almacena el audio de 10 estaciones de radio durante la transmisión que realizan de 6:00 a 24:00 horas, misma que se transcribe automáticamente utilizando un transcriptor llamado CMU Sphinx.

“Ya que se ha transcrito el audio, se pueden hacer búsquedas de la misma forma que se hace con las noticias de los periódicos. Podemos encontrar cuáles son los temas más importantes de lo que se está hablando o de cuántos temas se está hablando en cierto periodo de tiempo, utilizando técnicas de procesamiento de lenguaje natural”, apuntó Chirinos Colunga.

“Programamos lo que se llaman crawlers o arañas que 'suben' a las páginas de Internet y bajan su contenido. Son pequeños programas que se les dice a dónde ir y qué información buscar”.

El proyecto inició con el propósito de desarrollar una base de datos que sustente otras investigaciones del grupo de geointeligencia computacional, como la del doctor Alejandro Molina Villegas, experto en procesamiento de lenguaje natural (NLP, por sus siglas en inglés), la de Gandhi Hernández Chan, quien trabaja con identificación de emociones en texto, y la del doctor Oscar Sánchez Siordia, coordinador de la unidad Yucatán, quien trabaja con redes sociales y sobre identificación automática de conflictos violentos en notas de prensa.

Desarrollo tecnológico

El primer paso del proyecto fue escoger los periódicos más reconocidos, como La Jornada, que era el más óptimo debido a que almacena sus publicaciones de manera ordenada. Posteriormente se consultó ComScore, una página que hace un listado de los medios más importantes de comunicación.

“Escogimos los principales diarios nacionales y los dos primeros diarios locales de cada estado. En este momento tenemos 45 diarios, pero la idea es tener todos los diarios de circulación nacional y local”, apuntó Chirinos Colunga.

Una vez que la araña (crawler) descarga la información en un archivo de formato JSON (JavaScript Object Notation) y se almacena en la base de datos, permite que el usuario pueda buscar en dicha base cualquier información que desee a través de una plataforma intuitiva. “Tenemos dos millones 337 mil noticias al día de hoy y 26 mil 800 minutos de audio. El proyecto comenzó en agosto de 2017”, resaltó el investigador.

Procesamiento del lenguaje natural

De acuerdo con Alejandro Molina Villegas, el procesamiento de lenguaje natural tiene por objetivo que la computadora analice, entienda y derive significado a partir del lenguaje humano. “Es decir, se busca modelar los mecanismos necesarios para la comunicación humana pero por medio de programas de cómputo. Dichos modelos se enfocan no solo en el procesamiento simbólico del lenguaje, sino en su comprensión y en otros aspectos cognitivos”.

Para checar el listado completo, dar clic aquí.Para el investigador, el mayor reto del procesamiento de lenguaje natural es emular los aspectos cognitivos del ser humano y su manera eficiente de vincular pensamiento y lenguaje.

Para checar el listado completo, dar clic aquí.Para el investigador, el mayor reto del procesamiento de lenguaje natural es emular los aspectos cognitivos del ser humano y su manera eficiente de vincular pensamiento y lenguaje.

“En la década de los cuarenta, el matemático Alan Turing se planteó la cuestión de si una computadora podría llegar a pensar. Es decir, si es posible generar inteligencia artificial. Desde entonces, los científicos soñamos con poder conversar con un robot tal y como lo haríamos con una persona: expresando ideas abstractas en nuestro idioma”, describió.

En el proyecto M3, se busca utilizar procesamiento de lenguaje natural para generar modelos para la georreferenciación. “Por ejemplo, queremos detectar cuando se menciona un lugar o una entidad georreferenciable para luego obtener sus coordenadas”, apuntó el investigador.

Molina Villegas trabaja también en la identificación automática de temas por medio de técnicas de agrupamiento (clustering) para agrupar los documentos que hablan de temas similares, así como en la identificación de emociones en el texto.

De acuerdo con el especialista, el área de modelización probabilística de tópicos (Probabilistic Topic Modeling) está basada en la idea de que un documento es una mezcla de temas (tópicos), donde un tema es definido como una distribución de probabilidad sobre las palabras.

“Esto tiene muchas aplicaciones interesantes, empezando por la posibilidad de agrupar semánticamente los documentos, de manera que aquellos que hablan de la misma mezcla de temas quedan juntos. Una vez programado, se puede correr el experimento para toda la biblioteca digital de una universidad. Los motores de búsqueda que utilizamos a diario funcionan con módulos como este”.

En la línea de análisis y reconocimiento de voz, Molina Villegas se ha interesado también en la clasificación automática de llamadas delictivas. Como resultado, desarrolló un programa que identifica cuándo está en curso una llamada de secuestro y permite emitir una alerta a las autoridades o a los familiares de la persona que recibe la llamada. “Estoy buscando financiamiento o capital semilla para ponerlo en una app”.

Esta obra cuyo autor es Agencia Informativa Conacyt está bajo una licencia de Reconocimiento 4.0 Internacional de Creative Commons.