Anabel Martín González: realidad mixta y sistemas automatizados

Por Marytere Narváez

Mérida, Yucatán. 4 de noviembre de 2016 (Agencia Informativa Conacyt).- Anabel Martín González, profesora investigadora de la Facultad de Matemáticas de la Universidad Autónoma de Yucatán (Uady), es una de las principales promotoras del desarrollo científico y tecnológico de los sistemas automatizados y la realidad aumentada, mediada y mixta en Yucatán.

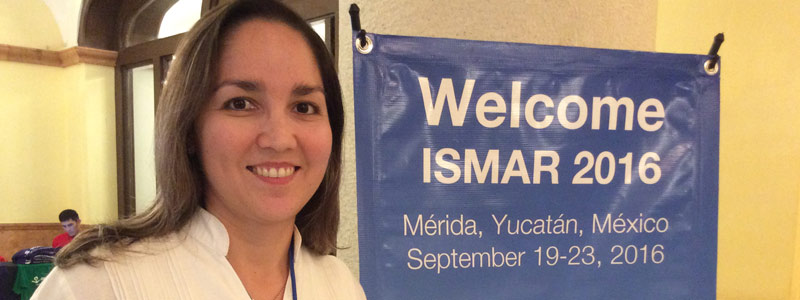

Recientemente, la investigadora yucateca fue parte del comité de organización del Simposio Internacional de Realidad Mixta y Aumentada (ISMAR, por sus siglas en inglés), uno de los eventos más importantes en el campo de las ciencias de la computación a nivel global.

Entrevistada por la Agencia Informativa Conacyt en el marco de ISMAR 2016, Anabel Martín González señaló que su incursión en el campo de la realidad mixta inició a partir de sus estudios de doctorado en la Universidad Tecnológica de Munich, en Alemania, donde le fue asignado un proyecto que tenía como fin mejorar la percepción visual de pacientes con degeneración macular, enfermedad en la que el ojo pierde progresivamente la visión central y empieza a ver las imágenes deformadas.

“Ahí aparece la idea de aplicar una solución de realidad mediada a través un visor que modela la deformación de la vista de la persona afectada, y a partir de ese modelo procesar la imagen proveniente de las cámaras hacia el video que se proyecta en los lentes del visor para invertir esa deformación, de tal forma que la persona pueda ver corregido lo que veía deformado”, apuntó.

Realidad mixta para la salud visual

De acuerdo con la investigadora, quien está adscrita con nivel de candidato en el Sistema Nacional de Investigadores (SNI), la realidad mixta, que se ramifica del campo de la realidad aumentada, no tiene como objetivo agregar información virtual a lo que se percibe en el exterior, sino modificar la forma de la percepción visual que un usuario tiene, por lo que en este caso tuvo la posibilidad de ayudar a personas con problemas visuales.

Para llevar a cabo este fin, el equipo de hardware (conocido en inglés como head-mounted display) estuvo conformado por un visor montable en la cabeza del usuario equipado con cámaras para percibir el entorno. El video proyectado al usuario era procesado para contener el modelo inverso de deformación visual y corregir así dicho trastorno.

“Lo que nosotros hicimos fue hacer el proceso de modelación de visión afectada más interactivo. Presentamos en la computadora la malla Amsler grid, utilizada por los oftalmólogos para encontrar los puntos ciegos de un paciente, la persona se sentaba, se cubría un ojo, fijaba la visión en el punto central del mallado e indicaba con el dedo la línea que veía deforme hacia algún lado. Entonces, un asistente deformaba el mallado en el sentido contrario de lo que la persona indicaba, de manera que esta lo notara menos deformado”, apuntó.

Realizando la prueba un determinado número de veces, se encontraba la forma que debía tener el modelado de todas las partes afectadas de la visión, mismo que entraba al proceso de inversión de la imagen para que el usuario pudiera verla lo más derecha posible.

Realizando la prueba un determinado número de veces, se encontraba la forma que debía tener el modelado de todas las partes afectadas de la visión, mismo que entraba al proceso de inversión de la imagen para que el usuario pudiera verla lo más derecha posible.

Para que la tecnología resultase más viable era necesario tener incluido en el visor un seguidor de ojo (eye tracker), de un gran nivel de precisión que indicara el punto exacto en donde el ojo mira para aplicar la deformación inversa, pero los seguidores de ojo actuales aún no tienen la suficiente velocidad para seguir puntualmente los movimientos oculares.

“Se quedó en un prototipo y en una solución para aplicarse de 10 a 15 años, cuando los rastreadores de ojo puedan ser más precisos. Pero la propuesta es interesante y viable si tenemos el hardware para realizarlo”, apuntó Martín González.

Adicionalmente, se requiere un procesamiento de imágenes para generar las deformaciones que neutralicen la deficiencia del ojo, así como un buen conocimiento del procesamiento de gráficos y de video para manejar las posiciones respecto de las cuales está el campo de visión del sujeto.

Paralelamente, Anabel Martín González participó en el desarrollo de una lupa virtual para generar lentes que magnifiquen la visión de los usuarios mediante el procesamiento de imágenes y aumentos digitales.

“Aprovechamos esta aplicación para hacer algo de realidad mediada en el campo de la medicina. Usando cámaras de rastreo para identificar la posición de la cabeza del cirujano y el área de operación, cuando él observaba con el visor la zona a operar, esta se magnificaba, simulando la visión obtenida al mirar a través de un microscopio quirúrgico. Cuando él regresaba la vista para interactuar con alguien, pedir un instrumento o dar alguna indicación, regresaba la vista normal”, señaló.

Sistemas de aprendizaje automático

A su regreso a Yucatán, la investigadora se dedicó al desarrollo de software de aprendizaje automático (machine learning), asesorando a estudiantes de maestría y licenciatura en ciencias de la computación de la Facultad de Matemáticas de la Uady, principalmente en el área de procesamiento de imágenes con aprendizaje automático para el reconocimiento de objetos.

La investigadora comentó que usualmente el reconocimiento de iris es empleado para sistemas de seguridad, con el objetivo de identificar la existencia de ese iris en la base de datos para permitir el acceso a determinados sitios. Como parte de los proyectos desarrollados en la Uady, el reconocimiento de iris se empleó para desarrollar algoritmos de aprendizaje automático.

“En el proyecto se requirió aplicar procesamiento de imágenes para extraer las características específicas del iris, mismas que se clasificaron con una red neuronal artificial, que es parte del área de aprendizaje automático. Extraíamos esas características de puntos de interés específicos de la imagen para obtener un vector de características para entrenar los algoritmos de aprendizaje”, apuntó.

“En el proyecto se requirió aplicar procesamiento de imágenes para extraer las características específicas del iris, mismas que se clasificaron con una red neuronal artificial, que es parte del área de aprendizaje automático. Extraíamos esas características de puntos de interés específicos de la imagen para obtener un vector de características para entrenar los algoritmos de aprendizaje”, apuntó.

Cráteres lunares y lengua de señas en 3D

Un proyecto desarrollado como parte del programa de maestría de la Uady fue un detector de cráteres lunares para el área de astronomía. “Se sabe que de acuerdo con el número de cráteres en la superficie del astro, se puede identificar su edad, su incidencia de choques de asteroides y otras características que hablan acerca de la geografía y de la historia del astro. Detectando los cráteres, nosotros podemos hacer un conteo y tener algunas estadísticas”, señaló.

Asimismo, los estudiantes de la universidad han desarrollado un sistema de reconocimiento de señas para el área de lengua de señas mexicanas, ya que los sistemas actuales provienen mayormente de otros idiomas.

Con el sistema Kinect, los investigadores buscaron mejorar el reconocimiento que se puede tener con una cámara, que normalmente se utiliza para detectar rostros con características en dos dimensiones.

“Nosotros aprovechamos el sensor Kinect para tomar imágenes a profundidad y extrajimos características en tres dimensiones (3D), las metimos en una red neuronal artificial para su aprendizaje y se reconocieron 10 diferentes signos, cinco letras y cinco números”, apuntó.

Al aumentar la profundidad en tres dimensiones, se mejoró el reconocimiento del sistema de señas mexicano en comparación con los resultados obtenidos con características en dos dimensiones de otros sistemas desarrollados actualmente.

Esta obra cuyo autor es Agencia Informativa Conacyt está bajo una licencia de Reconocimiento 4.0 Internacional de Creative Commons.